一、概况

适用各种工作负载的出色计算平台

NVIDIA A100 Tensor Core GPU (中国区销售型号为:NVIDIA A800)可针对 AI、数据分析和高性能计算(HPC)应用,在各个规模下实现出色加速,有效助力全球高性能弹性数据中心。作为 NVIDIA 数据中心平台的引擎,相较于前一代NVIDIA Volta?,A100 可提供高达 20 倍的性能。A100 支持高效扩展,也可划分为七个独立的 GPU 实例,多实例 GPU (MIG)可提供统一平台,助力弹性数据中心动态地适应不断变化的工作负载需求。

NVIDIA A100 Tensor Core 技术支持广泛的数学精度,可针对每个工作负载提供单个加速器。最新一代 A100 80GB 将 GPU 显存加倍,提供 2TB/s 的全球超快显存带宽,可加速处理超大型模型和海量

数据集。

A100 是完整 NVIDIA 数据中心解决方案的一部分,该解决方案由硬件、网络、软件、库以及 NGC? 中经优化的 AI 模型和应用等叠加而成。作为性能超强的端到端数据中心专用 AI 和 HPC 平台,

它可助力研究人员交付真实的结果,并将解决方案大规模部署到生产环境中。

二、创新

>>NVIDIA AMPERE 架构

无论是使用 MIG 将 A100 GPU 分割为较小的实例,还是使用 NVLink连接多个 GPU 来加速大规模工作负载,A100 均可轻松满足不同规模的加速需求,从小型作业到大型多节点工作负载无一例外。

A100 功能全面,这意味着 IT 经理可借此全天候充分利用数据中心内的每个 GPU。

>>第三代 TENSOR CORE 技术

NVIDIA A100 的深度学习运算能力可达 312 teraFLOPS(TFLOPS)。其深度学习训练的Tensor 每秒浮点运算次数(FLOPS)和推理的 Tensor 每秒万亿次运算次数(TOPS)皆为

NVIDIA Volta? GPU 的 20 倍。

>>新一代 NVLINK

A100 中采用的 NVIDIA NVLink 可提供两倍于上一代的吞吐量。与 NVIDIA NVSwitch? 结合使用时,此技术可将多达 16 个 A100 GPU 互联,并将速度提升至 600GB/s,从而在单个服务器上实现出色的应用性能。NVLink 技术可应用在 A100 中:SXM GPU 通过 HGX A100 服务器主板连接,PCIe GPU 通过 NVLink 桥接器可桥接多达 2 个 GPU。

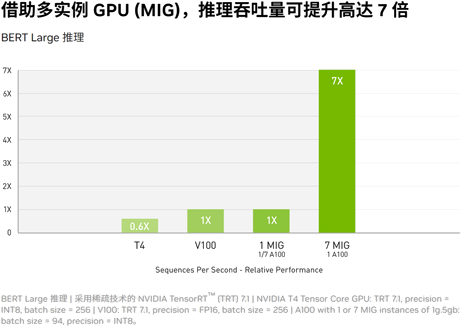

>>多实例 GPU (MIG)

一个 A100 GPU 最多可分割成七个GPU 实例,这些实例在硬件级别完全独立,并独自拥有高带宽显存、缓存和计算核心。借助 MIG,开发者可为其所有应用实现惊人加速,IT 管理员也可为每个作业提供符合其规模的 GPU 加速,进而优化GPU 利用率,并让每个用户和应用都能使用 GPU实例。

>>高带宽显存(HBM2E)

凭借 80GB 的高带宽显存(HBM2e),A100 成为世界首款将显存带宽提升至超过 2TB/s 的GPU,并将动态随机存取存储器(DRAM)的利用效率提高至 95%。A100 提供的显存带宽是上一代产品的 1.7 倍。

>>结构化稀疏

AI 网络拥有数百万至数十亿个参数。实现准确预测并非要使用所有参数,而且我们还可将某些参数转换为零,以在无损准确性的前提下使模型变得“稀疏”。A100 中的 Tensor Core 可令稀疏模型的性能获得高达两倍的提升。稀疏功能不仅更容易使 AI 推理受益,同时还能提升模型的训练性能。

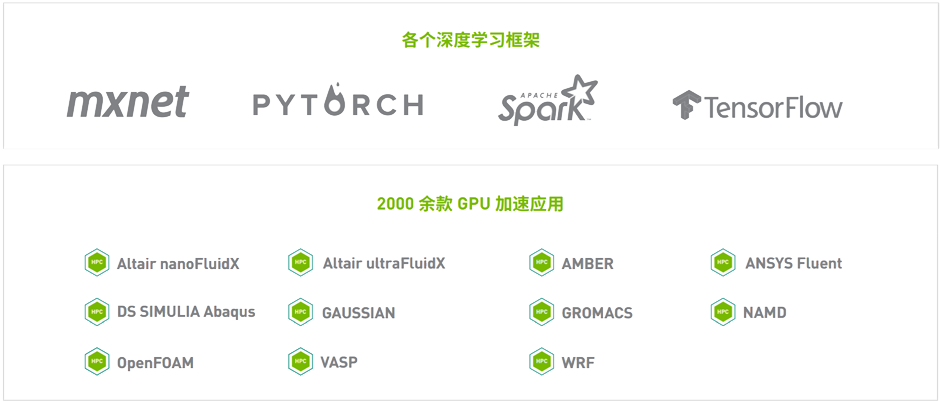

三、应用

NVIDIA A100 Tensor Core GPU 是 NVIDIA 数据中心平台的旗舰产品,可用于深度学习、HPC 和数据分析。该平台可为 2000 余款应用和各大深度学习框架提供加速。A100适用于桌面、服务器以及云服务,不仅能显著提升性能,还能创造众多节约成本的机会。

>>深度学习训练

当今的 AI 模型面临着对话式 AI 等更高层次的挑战,这促使其复杂度呈爆炸式增长。训练这些模型需要大规模的计算能力和可扩展性。

NVIDIA A100 Tensor Core 借助 Tensor 浮点运算 (TF32) 精度,可提供比 NVIDIA Volta 高 20 倍之多的性能,并且无需更改代码;若使用自动混合精度和 FP16,性能可进一步提升 2 倍。与 NVIDIA? NVLink?、NVIDIA NVSwitch?、PCIe 4.0、NVIDIA? InfiniBand? 和 NVIDIA Magnum IO? SDK 结合使用时,它能扩展到数千个 A100 GPU。

2048 个 A100 GPU 可在一分钟内成规模地处理 BERT 之类的训练工作负载,这是非常快速的解决问题速度。

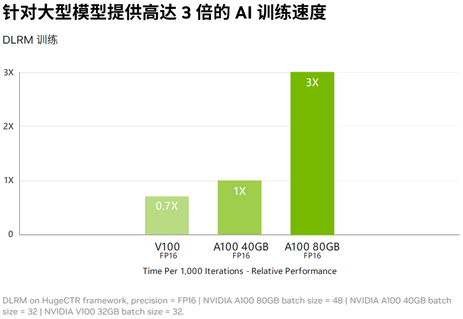

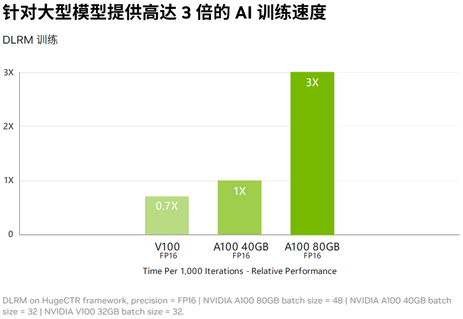

对于具有庞大数据表的超大型模型(例如深度学习推荐模型 [DLRM]),A100 80GB 可为每个节点提供高达 1.3TB 的统一显存,而且吞吐量比 A100 40GB 多高达 3 倍。

NVIDIA 的领先地位在 MLPerf 这个行业级 AI 训练基准测试中得到印证,创下多项性能纪录。

>>深度学习推理

A100 引入了突破性的功能来优化推理工作负载。它能在从 FP32 到 INT4 的整个精度范围内进行加速。多实例 GPU (MIG) 技术允许多个网络同时基于单个 A100 运行,从而优化计算资源的利用率。在 A100 其他推理性能增益的基础之上,仅结构稀疏支持一项就能带来高达两倍的性能提升。

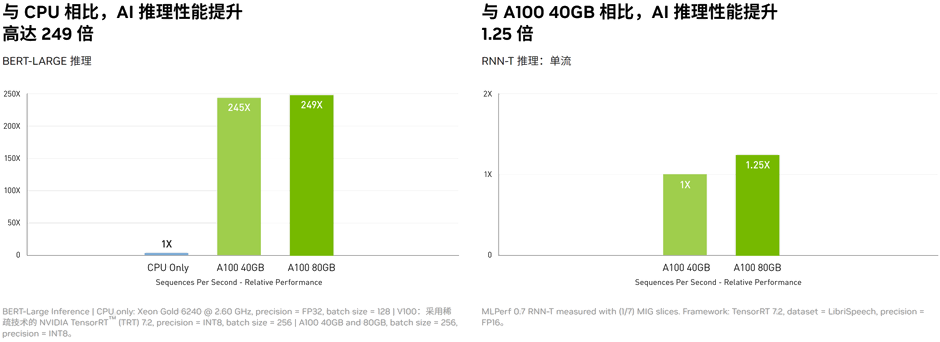

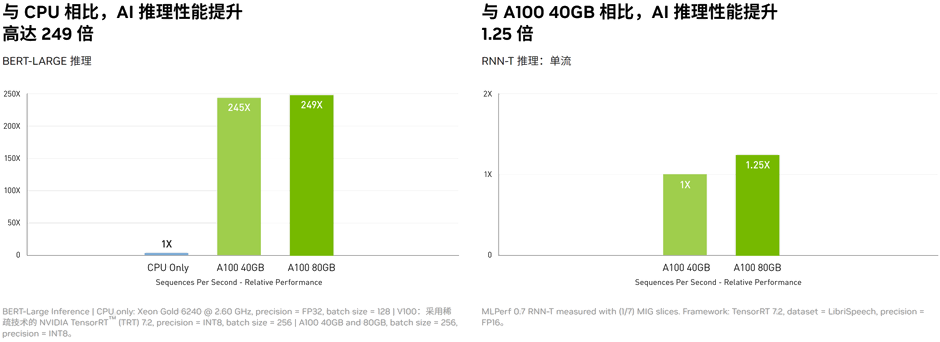

在 BERT 等先进的对话式 AI 模型上,A100 可将推理吞吐量提升到高达 CPU 的 249 倍。

在受到批量大小限制的极复杂模型(例如用于自动语音识别用途的 RNN-T)上,显存容量有所增加的 A100 80GB 能使每个 MIG 的大小增加一倍,并提供比 A100 40GB 高 1.25 倍的吞吐量。

NVIDIA 产品的出色性能在 MLPerf 推理测试中得到验证。A100 再将性能提升了 20 倍,进一步扩大了这种性能优势。

>>高性能计算

为了获得新一代的发现成果,科学家们希望通过仿真来更好地了解我们周围的世界。

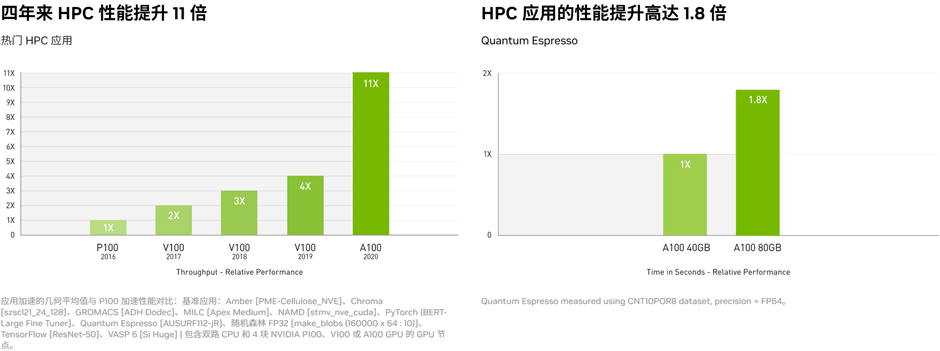

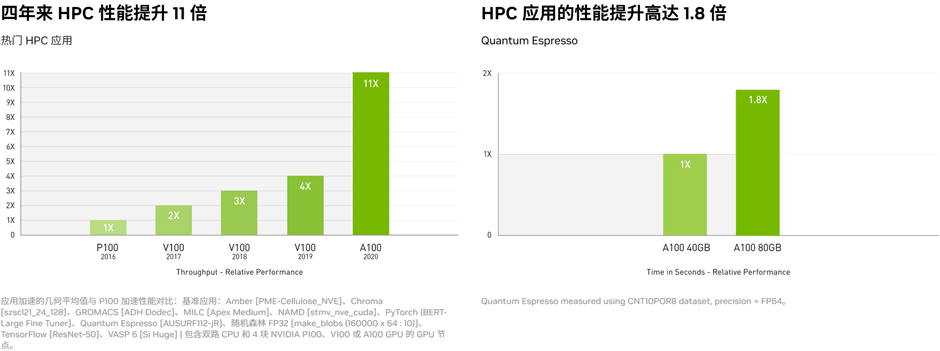

NVIDIA A100 采用双精度 Tensor Core,实现了自 GPU 推出以来高性能计算性能的巨大飞跃。结合 80GB 的超快 GPU 显存,研究人员可以在 A100 上将 10 小时双精度仿真缩短到 4 小时以内。HPC 应用还可以利用 TF32 将单精度、密集矩阵乘法运算的吞吐量提高高达 10 倍。

对于具有超大数据集的高性能计算应用,显存容量增加的 A100 80GB 可在运行材料仿真 Quantum Espresso 时将吞吐量提升高达 2 倍。极大的显存容量和超快速的显存带宽使 A100 80GB 非常适合用作新一代工作负载的平台。

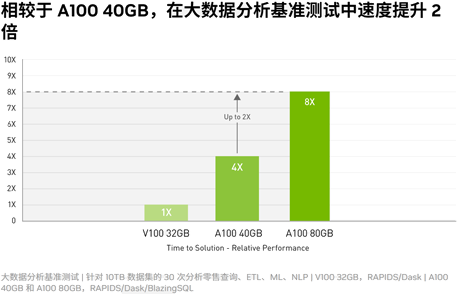

>>高性能数据分析

数据科学家需要能够分析和可视化庞大的数据集,并将其转化为宝贵见解。但是,由于数据集分散在多台服务器上,横向扩展解决方案往往会陷入困境。

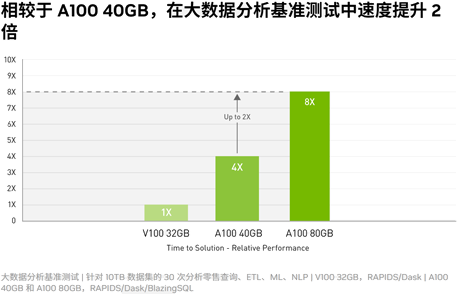

搭载 A100 的加速服务器可以提供必要的计算能力,并能利用大容量显存、超过 2 TB/s 的显存带宽以及通过 NVIDIA? NVLink? 和 NVSwitch? 实现的可扩展性,处理这些工作负载。通过结合 InfiniBand、NVIDIA Magnum IO? 和 RAPIDS? 开源库套件(包括用于执行 GPU 加速的数据分析的 RAPIDS Accelerator for Apache Spark),NVIDIA 数据中心平台能够加速这些大型工作负载,并实现超高的性能和效率水平。

在大数据分析基准测试中,A100 80GB 提供的见解吞吐量比 A100 40GB 高两倍,因此非常适合处理数据集大小急增的新型工作负载。

>>为企业提高资源利用率

A100 结合 MIG 技术可以更大限度地提高 GPU 加速的基础设施的利用率。借助 MIG,A100 GPU 可划分为多达 7 个独立实例,让多个用户都能使用 GPU 加速功能。借助 A100 40GB,每个 MIG 实例可分配多达 5GB,而随着 A100 80GB 显存容量的增加,此大小可翻倍至 10GB。

MIG 与 Kubernetes、容器和基于服务器虚拟化平台的服务器虚拟化配合使用。MIG 可让基础设施管理者为每项作业提供大小合适的 GPU,同时确保服务质量 (QoS),从而扩大加速计算资源的影响范围,以覆盖每位用户。

面向企业的优化软件和服务

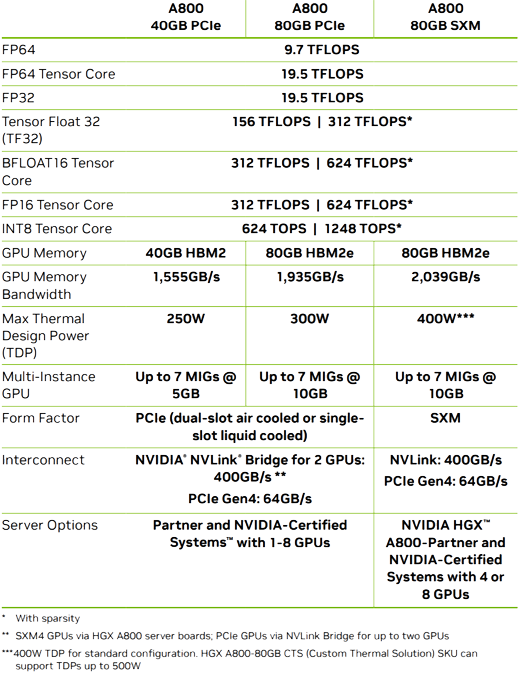

四、规格参数